elasticsearch 安装中文分词

写在前面

为什么要在elasticsearch中要使用ik这样的中文分词呢,那是因为es提供的分词是英文分词,对于中文的分词就做的非常不好了,因此我们需要一个中文分词器来用于搜索和使用。今天我们就尝试安装下IK分词。

IK 分词器简介

-

Elasticsearch中文分词我们采用Ik分词,ik有两种分词模式,ik_max_word,和ik_smart模式

-

ik_max_word 和 ik_smart 什么区别

ik_max_word: 会将文本做最细粒度的拆分,比如会将“中华人民共和国国歌”拆分为“中华人民共和国,中华人民,中华,华人,人民共和国,人民,人,民,共和国,共和,和,国国,国歌”,会穷尽各种可能的组合;

ik_smart: 会做最粗粒度的拆分,比如会将“中华人民共和国国歌”拆分为“中华人民共和国,国歌”。索引时,为了提供索引的覆盖范围,通常会采用ik_max_word分析器,会以最细粒度分词索引,搜索时为了提高搜索准确度,会采用ik_smart分析器,会以粗粒度分词

安装方法

第一种

-

去github 下载对应的分词插件

根据不同版本下载不同的分词插件,下载地址:elasticsearch-analysis-ik -

到es的plugins 目录创建文件夹

cd your-es-root/plugins/ && mkdir ik -

解压ik分词插件到ik文件夹

unzip elasticsearch-analysis-ik-6.4.3.zip

第二种

还有一种方式 直接通过es的命令进行安装,es版本需要大于5.5.1

./bin/elasticsearch-plugin install https://github.com/medcl/elasticsearch-analysis-ik/releases/download/v6.3.0/elasticsearch-analysis-ik-6.3.0.zip安装好后 重启es

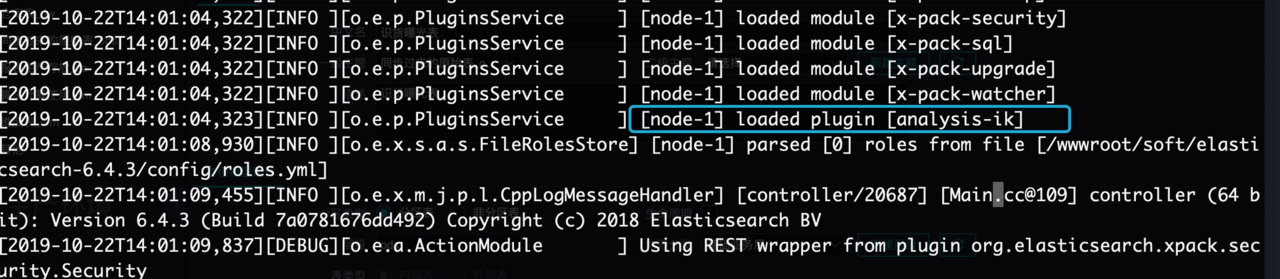

会看到 加载了 ik分词了